决策Tree方法用于风险决策,即在比较和选择活动计划时,未来情况不止一种,管理者无法确定哪种情况会发生,但知道每种情况发生的概率,所以采用这样的信息论方法会有效的减少对象分离所需的次数,从而保证生成的决策tree是最简单的,1.实验目的1,实验原理决策tree是最常见的分类算法,包含很多不同的变体。

采用答案的方法是正确的,但数字是错误的,所以很可能是粗心。

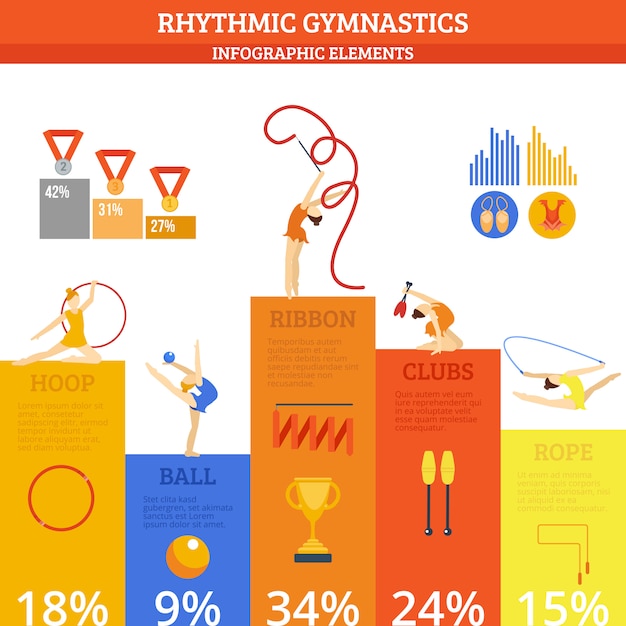

决策 Tree方法用于风险决策,即在比较和选择活动计划时,未来情况不止一种,管理者无法确定哪种情况会发生,但知道每种情况发生的概率。决策用树形法描述不同情况下的各种方案]×10-300=340(万元)方案二的预期收益为:-140=230(万元)。至于方案3,节点4的预期收益为465万元,大于节点5的预期收益,所以卖的不错。方案3(节点③)的预期收益为-140=359.5(万元)。计算结果表明,在三种方案中,方案3最好在复杂决策 tree中考虑利率(货币的时间价值因素),并做一个简单的模型来计算收益或在决策 tree之后。

可以去找信用卡风险评估的spsshelpcasestudy,是用决策 tree做的,还有评分模型和树中缺失值的处理方法,但必须是spss13以上。spss13集成了spss公司的answertree,answertree是专门用决策 tree做的。

4、 决策树——ID3算法应用 实例在ID3 决策 tree归纳方法中,通常使用信息增益法来帮助确定生成每个节点时要使用的适当属性。这样,可以选择信息增益最高(熵减程度最大)的属性作为当前节点的测试属性,从而最小化对后面划分的训练样本子集进行分类所需的信息,也就是说,使用该属性划分当前(包含节点的)样本集,将最小化生成的样本子集中的“不同类别的混合程度”,所以采用这样的信息论方法会有效的减少对象分离所需的次数,从而保证生成的决策 tree是最简单的。1.实验目的1,理解分类2。掌握分类挖掘算法ID33,为改进ID3打下基础。2.实验内容1,选择数据集(可在教学中参考)2。选择合适的实现环境和工具来实现算法ID33,给出分类规则3。实验原理决策 tree是最常见的分类算法,包含很多不同的变体,ID3算法最重要的部分是信息熵和信息增益的计算。

文章TAG:项目管理决策树画法的实例 决策 tree 项目管理 画法 实例